IA, comprendre les enjeux pour profiter des bénéfices

Par Cécilia Garcia Podoley

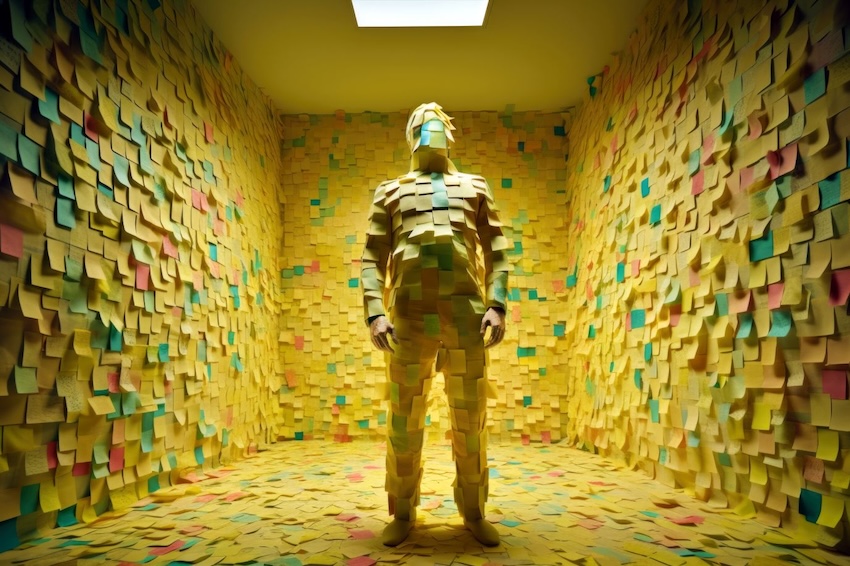

Voici mon troisième article, avec un peu de retard (j’espère que cela ne vous a pas échappé !). Je suis en train de finaliser mon projet de fin d’études pour un cours sur la Gouvernance de l’IA, et cela fait quelques semaines que je cherche les mots justes pour achever mon guide sur l’éthique et les compromis que nous faisons en tant qu’utilisateurs d’IA. Vous vous demandez certainement de quoi je parle… Eh bien, chaque fois que nous communiquons des informations à une IA, nous les mettons souvent dans le domaine public, y compris des informations très privées. Le titre de l’article fait référence à la conscience des enjeux (« Tech Savvy ») ou à l’ignorance de la destination de nos informations (« Tech Sorry »). Mon objectif est de vous fournir les principes et points de réflexion essentiels pour naviguer dans un monde de plus en plus automatisé.

Nous avons déjà discuté des principes éthiques qui devraient guider l’IA pour qu’elle serve l’humain (ou, au moins, pour qu’elle ne cause pas de dégâts). Une complexité supplémentaire réside dans le fait que nous ignorons souvent où vont nos informations. Cela vous inquiète-t-il ? Ou bien trouvez-vous agréable que votre voiture se souvienne d’ouvrir la fenêtre chaque fois que vous arrivez au parking de l’hôpital, même si cela signifie que vos visites hebdomadaires à un centre de santé sont enregistrées quelque part ? Est-ce que le confort prime sur la confidentialité ? Et que dire du fait que votre carte de fidélité de supermarché peut fournir des informations très précises à l’entreprise pour des publicités personnalisées ? Comment réagiriez-vous si, tout d’un coup, votre supermarché vous envoyait des publicités pour l’incontinence parce que vos achats indiquent que vous êtes entrée en ménopause ? Gênant, invasion de la vie privée ou « c’est la vie » ?

Je viens de vous donner des exemples un peu exagérés, mais il y a aussi des situations où les enjeux sont beaucoup plus critiques. Par exemple, saviez-vous que la plupart des systèmes de recrutement utilisant une IA discriminent contre les femmes ? Et que les systèmes de reconnaissance faciale ont une marge d’erreur très élevée pour les personnes de couleur ? Et encore, que le système « Compass » utilisé aux États-Unis pour évaluer le potentiel de récidive attribue des scores plus élevés aux personnes noires, même lorsque le crime en question est moins grave que celui d’une personne blanche ? L’IA est un outil comme tant d’autres, et peut être utilisé pour le bien ou le mal, mais il faut être conscient que la technologie n’est pas infaillible : les systèmes ont été créés par des humains avec des opinions, des pensées et des biais qui sont, d’une manière ou d’une autre, transmis à l’outil.

Il faut garder un esprit critique et comprendre les enjeux pour pouvoir profiter des bénéfices de l’IA. Chaque personne a la liberté de choisir quels compromis accepter. Pour cela, il faut être informé, poser des questions et refuser les situations qui ne nous conviennent pas. Il ne faut pas avoir peur, mais il ne faut pas non plus avoir une confiance aveugle. J’espère pouvoir vous présenter mon guide, le fruit de mon projet final, très prochainement.

Retrouvez l’ensemble de nos articles Inside